2015 wurde Kubernetes in der Version 1 veröffentlicht. , das erstmals Dual-Stack-Betrieb in einem Cluster unterstützte, also die gleichzeitige Nutzung von IP-Adressen in den Formaten IPv4 und IPv6. Das wiederum erleichterte auch die Kubernetes-Integration in Cloudumgebungen diverser Anbieter.

Neu hinzu kam auch die verbesserte Version v2 des Horizontal Pod Autoscaler für das automatische Skalieren derAnzahl der Pods eines Replication Controller, Deployments oder Replikat-Sets.

Momentan erscheint etwa alle vier Monate ein neues Release, dazwischen weitere Alpha- und Beta-Versionen zum Austesten der neuesten Funktionen und Fehlerkorrekturen (“Patchreleases”). Innerhalb weniger Wochen reagieren meist auch alle großen Cloudanbieter auf die Fortschreibungen bei Kubernetes und geben ihre Produkte und Schnittstellen für die neuen Versionen frei. Auch dies zeigt die große Bedeutung, die Kubernetes im Cloud-Sektor inzwischen erreicht hat.

Ende 2025 wurde Release 1.34 mit weiteren Neuerungen veröffentlicht. Kubernetes verwendet die von Menschen lesbare Daten-Beschreibungssprache YAML („Yet Another Markup Language“) um das Einbinden bestimmter Anwendungen in Infrastrukturen zu definieren.

In Kubernetes wird diese Sprache auch als Kubernetes-YAML, kurz: KYAML bezeichnet. Mit Kubernetes 1.34 wird ein neuer YAML-Dialekt in Kubernetes eingebunden, um die Konfiguration zu vereinfachen. Das Ziel: typische Anwenderfehler bei der Nutzung des alten Dialekts zu minimieren.

Kubernetes ist inzwischen mit vielen anderen Cloud-basierten Plattformen wie Azure oder AWS kompatibel und wird auf diesen als Ergänzung eingesetzt.

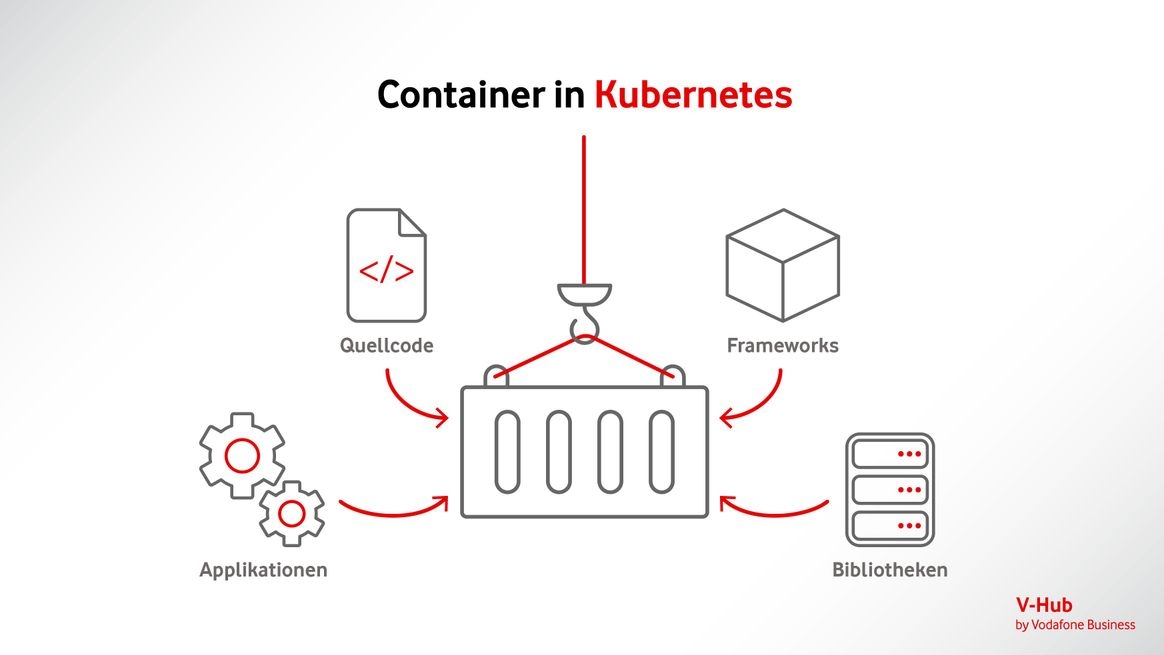

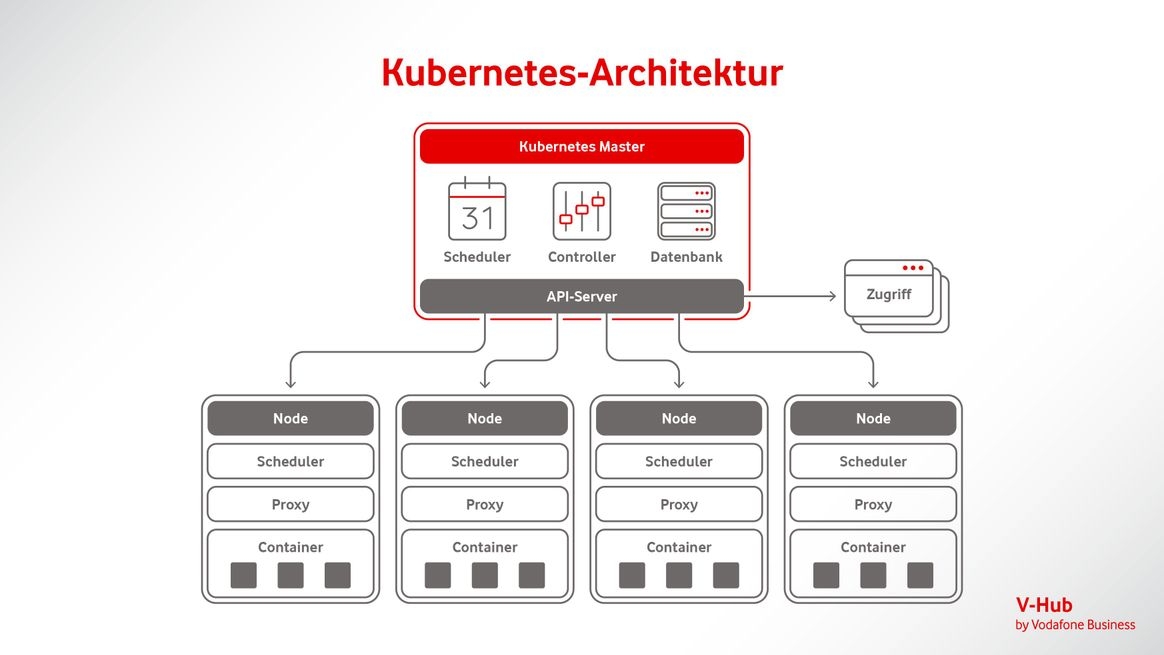

Dreh- und Angelpunkt sind dabei die Automatisierung von Prozessen und der Einsatz von sogenannten Containern für Anwendungen und Software-Umgebungen. Umfassende Unterstützung bei der Entwicklung leisten neben der Cloud Native Computing Foundation (CNCF) führende Tech-Unternehmen wie (weiterhin) Google, AWS, Microsoft, IBM, Intel, Cisco und Red Hat.

Azure Kubernetes Service (AKS) ist stark in Microsoft-Dienste wie Active Directory und Monitor integriert. Es kann sehr einfach über das Azure-Portal verwaltet werden.

Amazon Elastic Kubernetes Service (EKS) ist gut skalierbar. Es kann leicht mit anderen AWS-Services wie IAM, CloudWatch und Fargate kombiniert werden. Dafür ist die Konfiguration insgesamt deutlich aufwändiger.

Die Google Kubernetes Engine (GKE) bieten einen klaren „Heimvorteil“, da sie vom Kubernetes-Entwickler Google selbst stammt. Außerdem lässt sich die GKE erwartungsgemäß gut mit anderen Google Cloud-Diensten verbinden.

Die Entscheidung für ein Produkt sollte also weniger von der Kubernetes-Nutzung allein, sondern vom gesamten Anforderungsprofil im Unternehmen bestimmt werden. Hierbei sollten folgende Fragen berücksichtigt werden:

Welche Anwendungen laufen darüber hinaus in der Cloud? Welche SaaS-Pakete werden genutzt oder sollen angebunden werden?

Welche weiteren Cloud-Produkte sind bereits im Unternehmen abonniert? Soll die Cloud weiter diversifiziert werden oder nicht?

Welche darüber hinaus gehenden Anforderungen werden gestellt? Wichtige Stichworte: Cloudstandorte, Datensicherheit, Kostenmodelle.

Alternative Cloud-Angebote: Der Sovereign Cloud Stack (SCS)

Mit dem Sovereign Cloud Stack (SCS) entsteht seit 2019 ein europäisches Open-Source-Projekt für das Cloud-Computing in einer Sovereign Cloud. Als Teil der europäischen Gaia-X-Initiative dient es der Schaffung sicherer, vernetzter Datenräume abseits außereuropäischer Hyperscaler. Angesiedelt ist das staatlich geförderte Projekt bei der OSB Alliance, dem Bundesverband für digitale Souveränität, der Vertretung der deutschen Open- Source-Anbieter. Nach Fertigstellung soll das Framework den Rahmen für freie Kubernetes-Plattformen schaffen, die so weit standardisiert sind, dass Cloud-Provider sogenannte Kubernetes-as-a-Service-Produkte darauf anbieten und betreiben können.