Kubernetes wird in Beschreibungen häufig als K8s oder Kube in Anlehnung an den Begriff Cube abgekürzt. Die Schreibweise K8s kommt von dem Anfangsbuchstaben „K“ bei Kubernetes, dem dann acht Zeichen folgen und das Wort mit einem „s“ abschließen. Der gute Ruf, den Kube unter Entwickler:innen genießt, dürfte seine Ursachen in der von Google gelegten Basis des Projektes haben. Viele sprechen davon, dass Kubernetes Teil von Googles Bemühungen ist, die Cloud zu konsolidieren.2014 wurde Kubernetes an die eigens dafür gegründete Cloud Native Computing Foundation (CNCF) gespendet. Die CNCF sorgt seitdem für die Weiterentwicklung und Betreuung – auch von anderen Open-Source-Projekten wie beispielsweise Prometheus und Envoy.

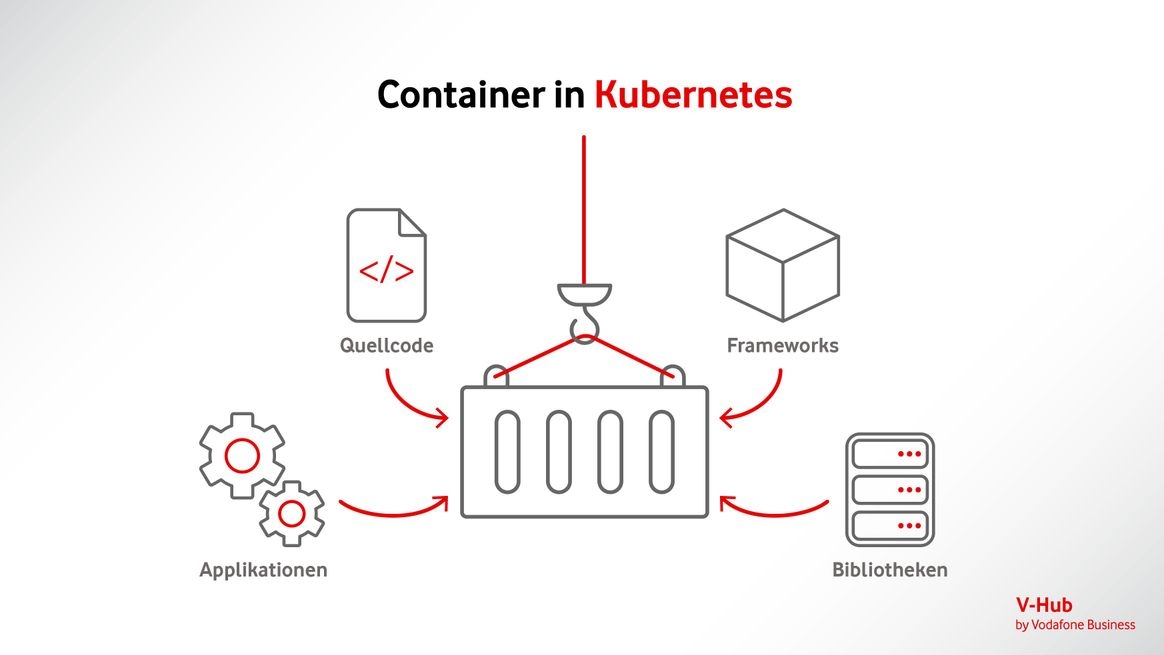

2015 wurde Kubernetes in der Version 1 veröffentlicht, im März 2022 erschien das Release 1.23.5. Kubernetes ist inzwischen mit vielen anderen Cloud-basierten Plattformen wie Azure oder AWS kompatibel und wird auf diesen als Ergänzung eingesetzt. Dreh- und Angelpunkt sind dabei die Automatisierung von Prozessen und der Einsatz von sogenannten Containern für Anwendungen und Software-Umgebungen. Umfassende Unterstützung bei der Entwicklung leisten neben der Cloud Native Computing Foundation (CNCF) führende Tech-Unternehmen wie (weiterhin) Google, AWS, Microsoft, IBM, Intel, Cisco und Red Hat.

Kubernetes wird häufig auch als „Betriebssystem für die Cloud” bezeichnet. Für Kubernetes geschriebene Anwendungen können überall dort laufen, wo es Kubernetes gibt. Was bei Linux und anderen plattformunabhängigen Betriebssystemen auf Desktop- und Serverebene zum Erfolg führte, passiert aktuell im Cloud-Bereich mit Kubernetes.

Und so verwundert es nicht, dass sich Kubernetes innerhalb weniger Jahre zum De-facto-Standard für Container-Orchestrierung entwickelt hat.

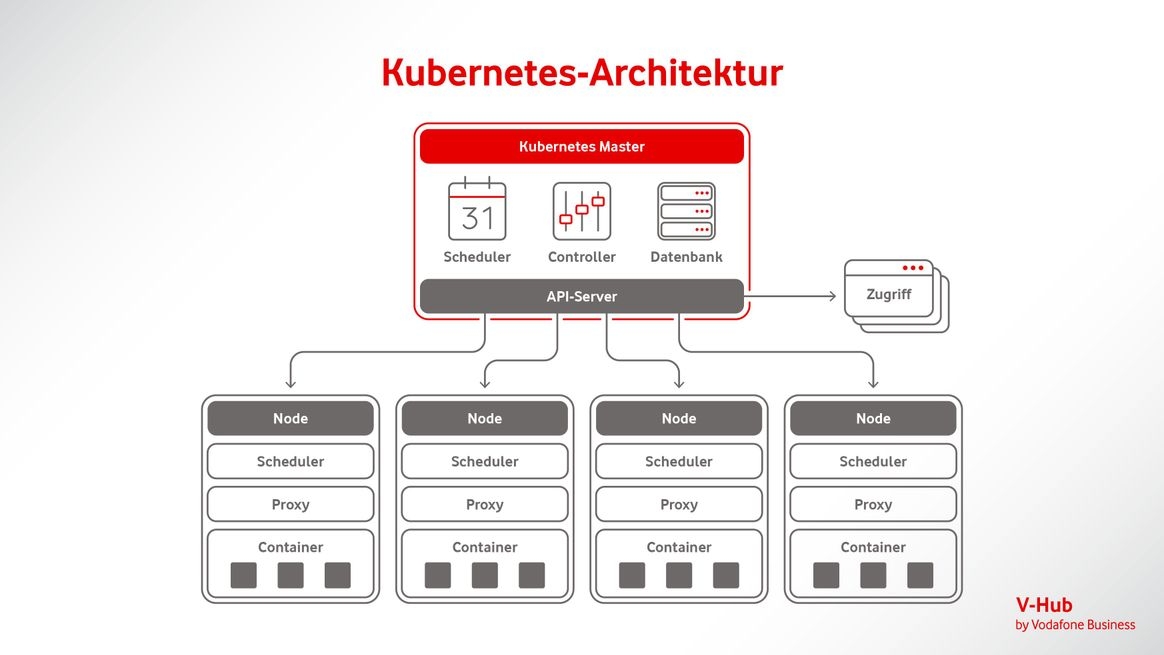

Das Container-Konzept bringt Flexibilität in Software-Entwicklungsprozesse. Dynamische Container-Umgebungen brauchen leistungsfähige Monitoring-Lösungen, die in der Lage sind, Daten zusammenzuführen. Kubernetes bietet in diesem Zusammenhang eine containerzentrierte Managementumgebung und koordiniert die Computer-, Netzwerk- und Speicherinfrastruktur in Abhängigkeit von den Workloads durch Benutzer:innen.